概要

ローカルCPUでLLMを動かす方法を以下で紹介しましたが、

その際にOpen WebUIでOllamaにいれたはずのモデルが見つからないということがあったので、

その解決方法を書いておきます。

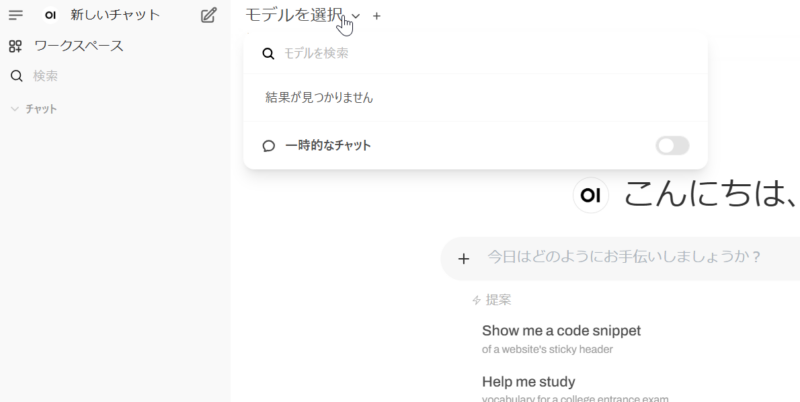

エラー内容

以下のようにモデル選択のところに何も表示されませんでした。

原因

Ollamaの接続先URLが間違っていることが原因でした。

解決方法

今回は、Dockerで起動している前提で進めていきますが、ローカルでOllamaを起動している場合は、おそらくエラーにならないかと思います。(デフォルトがlocalhostのようなので)

まずは、左側のアイコンから設定を表示します。

続いて、管理者設定を選択します。

その後、接続を選択すると以下のようなURL設定画面になります。

ここのOllamaURLを以下のように書き換えます。

http://host.docker.internal:11434

保存をクリックします。

これで、モデルが読み込まれると思います。