概要

以下記事では、ローカルCPUのみでLLMのチャットボットを作成する方法を紹介していますが、

この過程でInternal Errorが発生したので、その解決方法をメモしておきます。

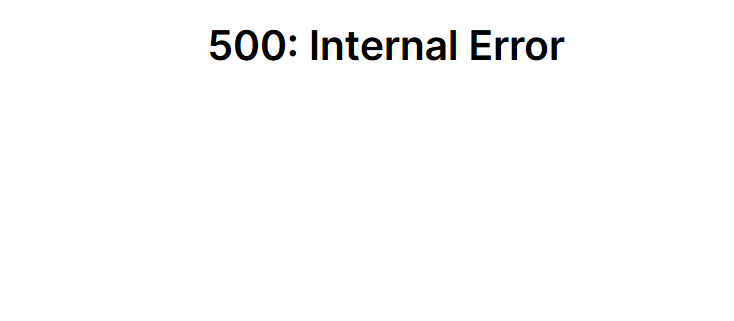

エラー概要

DockerでOllamaとOpen WebUIを起動後、

localhost:3000へのアクセスで以下のエラー画面が表示されました。

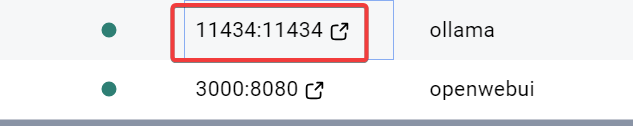

解決方法

localhost:3000にアクセスする前にOllamaを起動しているPortへのアクセスが必要のようです。

上述の記事で紹介しているコードの場合はlocalhost:11434

アクセスすると

となります。

これで再度localhost:3000にアクセスするとOpen WebUIが正常に起動します。

原因

キャッシュ関連の問題?

https://github.com/open-webui/open-webui/discussions/3800