この記事では、Google Colab環境でDeepseek-R1をOpen WebUIを使って実行する手順を紹介します。以下の手順を実行することで、Deepseek-R1をWebインターフェースで操作できるようになります。

必要なパッケージのインストール

まずは、curlを使ってインストールスクリプトを実行し、必要なパッケージをインストールします。

!curl -fsSL https://ollama.com/install.sh | sh

次に、Python 3.11とその開発パッケージをインストールします。

!sudo apt-get update

!sudo apt-get install -y python3.11 python3.11-venv python3.11-dev

Python仮想環境の作成

次に、Python 3.11を使って仮想環境を作成します。

!python3.11 -m venv venv

!source venv/bin/activate

仮想環境が有効化されたら、pipを最新の状態にアップグレードします。

!venv/bin/python -m pip install --upgrade pip

Open WebUIのインストール

次に、Open WebUIを仮想環境にインストールします。

!venv/bin/pip install open-webui

サーバー起動スクリプトの作成

次に、Deepseek-R1とOpen WebUIの両方のサーバーを非同期で起動するためのPythonスクリプトを作成します。

with open('start_servers.py', 'w') as f:

f.write('''

import subprocess

import threading

import os

import time

def start_ollama():

subprocess.run(['ollama', 'serve'], stdout=subprocess.DEVNULL, stderr=subprocess.DEVNULL)

def start_open_webui():

subprocess.run(['venv/bin/open-webui', 'serve', '--port', '8082'], stdout=subprocess.DEVNULL, stderr=subprocess.DEVNULL)

# Start servers in separate threads

threading.Thread(target=start_ollama).start()

time.sleep(5)

threading.Thread(target=start_open_webui).start()

''')

CUDAドライバーのインストール(オプション)

もしGPUを使用する場合は、CUDAドライバーをインストールします。

!curl https://ollama.ai/install.sh | sh

!echo 'debconf debconf/frontend select Noninteractive' | sudo debconf-set-selections

!sudo apt-get update && sudo apt-get install -y cuda-drivers

Deepseek-R1のインストール

Deepseek-R1のモデルをインストールするため、ollamaを使ってモデルをプルします。

!pip install ollama

!nohup ollama serve &

!ollama pull deepseek-r1:1.5b

サーバーの起動

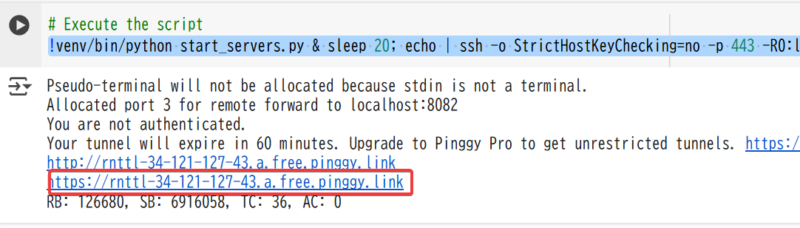

次に、作成したスクリプトを実行して、Deepseek-R1サーバーとOpen WebUIサーバーを起動します。

!venv/bin/python start_servers.py & sleep 20; echo | ssh -o StrictHostKeyChecking=no -p 443 -R0:localhost:8082 qr@a.pinggy.io

これで、Deepseek-R1とOpen WebUIの両方のサーバーが非同期で起動し、WebインターフェースでDeepseek-R1を操作できるようになります。

表示されるリンクをクリックします。

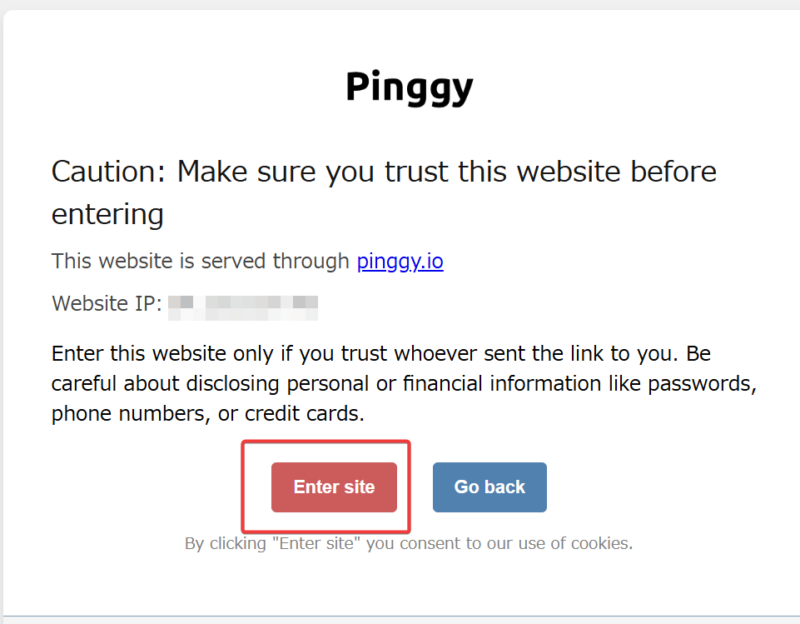

すると以下のような渓谷画面になりますが、続行します。

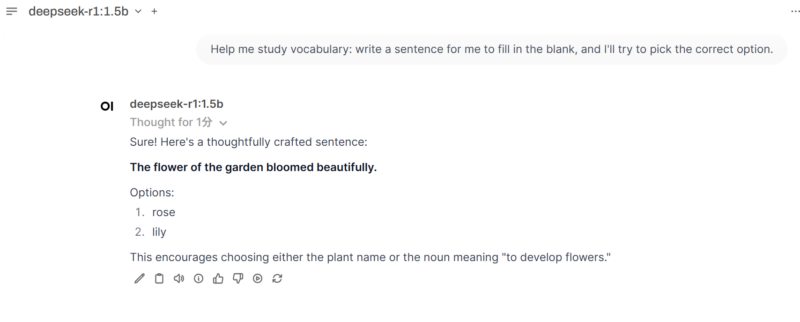

アカウント登録などを行うと、チャット画面になります。

CPUでもdeepseek-r1:1.5bであれば時間はかかりますが、何とか動かせます。

今回紹介したコードはこちらから確認できます。

以下コードを参考にさせていただきました。